モーションキャプチャー体験【後編】モーションキャプチャーの現在と未来 特別インタビュー!

取材写真:鈴木希代江

モーションキャプチャー体験後編!前編で紹介できなかったことや、モーションキャプチャー初心者でもわかるいろはを、エンジニアリングマネージャー・長野樹さんに解説していただきました。また、ゆにクリエイトさんのスタジオレンタルについてのお話もお聞きしたので、実際に3Dモデルを使用して配信したい!動画を撮りたい!という方も必見です!

INTERVIEW 長野樹

――モーションキャプチャーとは?

実際に人にセンサーを取り付けて、人の動きをデータとして扱えるようにしたものです。そのデータをどう使うかは業界によりますが、うちでは主に配信や動画撮影に使用しています。

――どんな種類があり、何が違うのでしょうか?

大きく分けて3種類ありまして、光学式、慣性式、ビデオ式です。

センサーをつけてカメラで読み取る光学式、センサーはつけますがセンサーの位置関係を計算してモーションデータにしている慣性式、ビデオや画像からモーションを読み取るビデオ式に分けられます。光学式はカメラでセンサーの位置を確認してモーションデータにしていて、慣性式はカメラ不要で持ち運びもでき、ビデオ式はスポーツでボールの軌道を検証するときなどに使われています。

――最も正確に動きを読み取ることができるのは光学式ですか?

やっぱり光学式が段違いで正確に読み取ることができます。慣性式は持ち運べるというのがメリットですが、どうしても磁気に弱く、外で電波が多い場所とか周りに携帯電話を使っている人がたくさんいる状況だとそっちに引っ張られてしまい、モーションデータが崩れやすいです。なので、慣性式はどうしても外でモーションキャプチャしたいという時によく使われています。どの種類も一長一短です。

――モーションキャプチャーの進化でできるようになったこと。

今までのモーションキャプチャーだと、大規模な設備のあるところでしかライブの撮影やキャラクター同士のやりとりが難しいところがありましたが、最近だと弊社のスタジオの規模感でもできるようになったところに進化をとても感じます。

ここ4〜5年で一気に技術が進歩していて、うちも3年前くらいから始めていますが、ここ1〜2年が特にすごいです。モーションキャプチャー業界自体も、VTuberが出てきたおかげで広まったというのもあります。VTuberが出てくる前は、映画業界やゲーム業界でしかモーションキャプチャーって使われていなかったので。

――ロボットなどにもモーションキャプチャーが使用されているというのを聞いたことがあるのですが。

最近のロボット技術だとなるべく人に近い動きをさせようとしていて、そこで人の動きのデータが必要になってくるので、そういう使い方も増えてきていますね。

また、「データとして欲しいのでスポーツの動きをモーションキャプチャーさせてください」っていう相談を受けたことがありまして、スポーツ医療やスポーツ科学といった面でもモーションキャプチャーは使われています。例えばプロ選手の動きのデータが取れれば、今まで1カメでしか確認できていなかった動作が色々な角度から見られるようになるので、それを使用してさらにレベルアップするために使用されたりしていますね。

――衣装や髪の毛などが動く仕組みは?

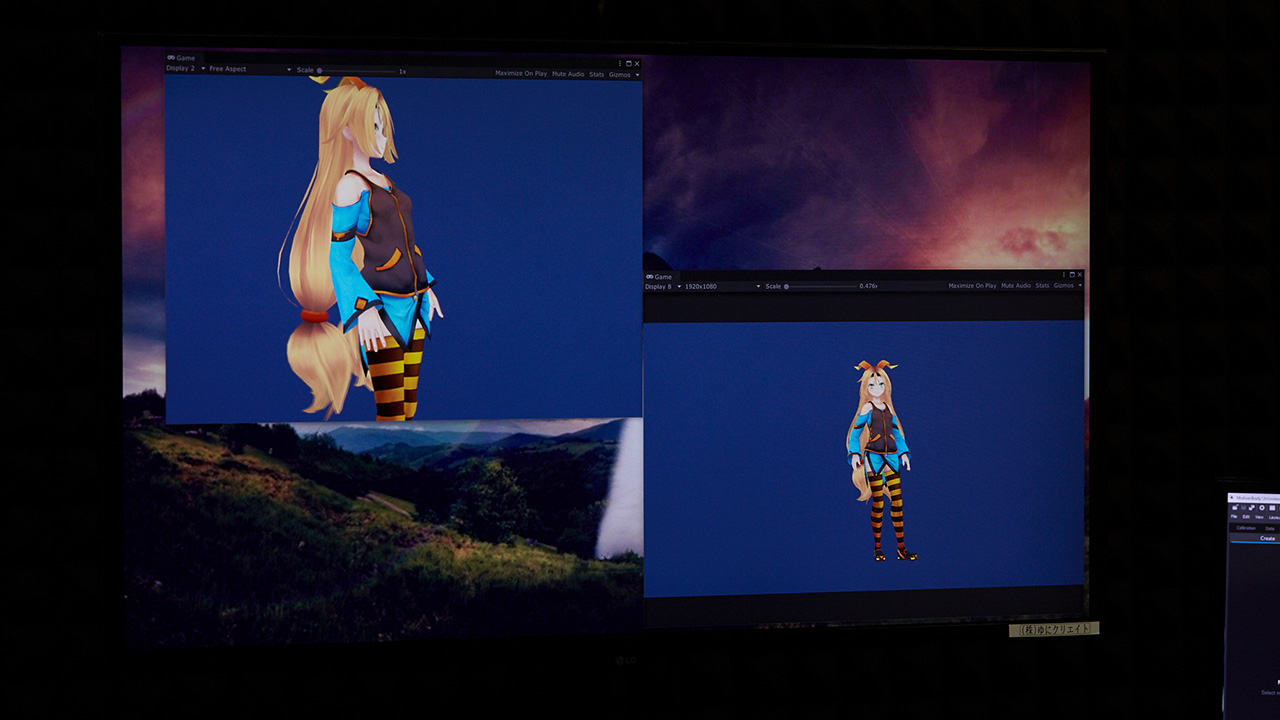

3DのキャラクターはゲームエンジンのUnityを使用して動かしており、モデルに設定されている揺れのプログラムがあるので、それをより自然に動くように調整して動かしています。お客様から3Dモデルをいただいた時にそのまま使用すると揺れものがあまり自然じゃない時があるので、事前にこちらで調整してやっています。揺れもの表現には自信があります。

――表情の変化について。

表情のモーションキャプチャー自体は弊社ではやっていないので、事前に表情のパターンを用意しておいてその時々に合わせてオペレート側で変更しています。モデルによって設定できる表情の数は異なりますが、基本は12パターンまで設定できます。瞬きも何秒に1回とプログラム上で設定し、口の動きはマイクで拾った音声から母音を検知して、それに合わせた口の動きになるようにしています。

――最近はフェイストラッキングも進化してきてスマホで表情を読み取れるようになっていますが、身体もマーカーなしで読み取ることができるようになりますか?

それに関しては我々も外でできないかと検証しているんですが、ここ1〜2年でスマホでも身体と表情全部読み取れるようになってきています。今はスマホのカメラで距離がわかるようになってきていて、空間把握ができるようになっているので、モーションキャプチャーに必要な一つの操作がスマホに備わったイメージです。スマホのスペックがまだ足りていないところがありますが、身体・表情全部動かして3Dのキャラを割り当てるっていうところまではできます。カクカクになったりするので技術的に足りないところはまだありますが、可能なところまではきています。あとは時間の問題かなと思います。

――人間の身長と3Dモデルの身長に差があっても違和感なく動く理由とは?

3Dモデルってゲームエンジンで動かすときに、ここは頭、ここは手という設定がされているんですが、その設定に対してモーションキャプチャー上で人のデータを割り当てているので、実際に身長差があってもきちんとその通りに動きます。ただ身長差や体格差があると、複数人での撮影の時に手を繋いだりハグするとキャラ同士の距離が遠いとかはどうしても起きてしまうので、ここに関してはアクターさんの位置やモデルの位置関係をソフト上で調整して対応しています。以前に犬を無理やりモデルに当てはめて、四つん這いになってもらって動かしたこともあります。

――ミニキャラと人間サイズを2体同時に動かす場合は、目線は合うものなんでしょうか?

どうしても中の人は大人なのでちょっとずれていますが、演者に頭を下げながら喋ってもらうなど調整してもらう必要があります。キャラ同士の目線を合わせるとなった場合は、ミニキャラのほうを台に乗っているという設定にして机のオブジェクトの上に置いて目線を合わせるなどしています。

――複数人で同時に撮影する際に、モデル同士が干渉したりはしませんか?

この前の大型アップデートで干渉はほぼなくなりました。ただ、うちのスタジオだと基本的には3人まででお願いしています。広さ的に4人まで可能ではありますが、たくさん動くので広く使って欲しいというのと、人が多くなるとそれだけ形が複雑になってモデルが崩れる可能性も高くなってしまうので。

――スタジオレンタルでされている、配信・収録それぞれのワークフローを教えてください。

【配信】

①事前に配信内容について打ち合わせ(演出など)

②当日までにプログラム作成、カメラの位置調整

③当日に事前リハーサルで細かな調整をする

④配信ソフトを使用して配信(YouTube、bilibili、Twitchなど配信可能なサイトならどこでも配信可)

【収録】

①事前に配信内容について打ち合わせ(演出など)

②当日までにプログラム作成、カメラの位置調整

③当日に事前リハーサルで細かな調整をする

④画面録画ソフトを使用し撮影

――配信レイアウトなど使用したい素材も持ち込みは可能ですか?

事前に使いたいレイアウトやテロップなどの素材をいただければ、こちらでセットできます。

――音声は?

ヘアバンドにマイクを取り付けたものがあるのでそこから音声を拾ってミキサーに落とし込んでいます。

――今後のモーションキャプチャーの進化と可能性について。

スマホでもできるようになってきているように、モーションキャプチャーがより身近になってきているので、もっと手軽にモーションキャプチャーができるような世の中があと2〜3年でくるんじゃないかなとは思います。進化という面では大手さんがほぼやっているので、スマホがあれば個人レベルでも手が出るようになってくるのではないでしょうか。

――ゆにクリエイトさんが今後挑戦したいものについて。

弊社だと3人のライブなどが今のところ最大なので、もっと大規模なライブだったり、リアルタイムでお客さんを入れた現実とバーチャルを繋ぐリアルイベントに挑戦していきたいです。あとはバンドや楽器の演奏もモーションキャプチャーでできたらいいなと考えています。過去の経験からタップダンスなどの激しい動きはできることがわかってるので、より難しい動きやまだやったことがないものを考えたときに、音楽演奏かなと。どのクオリティで再現できるかわかっていないので、挑戦していきたいです。

© Unity Technologies Japan/UCL

Profile

長野樹

株式会社ゆにクリエイトのエンジニアリングマネージャーとしてス

ゆにクリエイト

アニメ業界、ゲーム業界、出版業界、音楽業界など、